Les experts de cet éditeur américain ont mis au point des avatars suffisamment réalistes pour être pris pour de vraies personnes. De quoi berner un système de reconnaissance faciale aéroportuaire. Mais aussi les agents de contrôle d’identité…

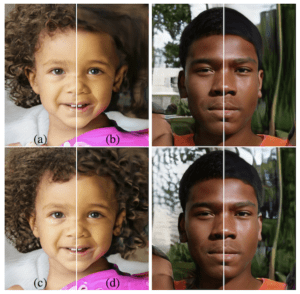

Exemple de variations d’avatars de StyleGAN selon deux visages.

© GAN

Outre la violation des libertés publiques et les failles dues aux biais, la reconnaissance faciale fait l’objet d’une nouvelle critique. Des chercheurs de l’Advanced Threat Research (ATR) de McAfee ont trouvé un nouveau moyen de tromper cette technologie controversée. Cette fois-ci, les experts n’ont pas invoqué les biais raciaux ou sexistes mais se sont attaqués à l’IA même du système. Concrètement, ils ont mis au point une illusion qui consiste à tromper la reconnaissance faciale. L’amenant ainsi à prendre une personne pour une autre.

Un système basé sur le Model Hacking

Pour prouver la vulnérabilité de la biométrie faciale, les chercheurs se sont servis d’un Adversarial Machine Learning (AML). Il s’agit d’un Model Hacking qui consiste à percer les failles des algorithmes d’intelligence artificielle. À l’instar du Machine Learning, cette technique se base sur un apprentissage en continu via la technologie Generative Adversarial Network (GAN). Laquelle consiste à détecter les nouvelles menaces pour mieux s’en prémunir.

La reconnaissance faciale pour le contrôle d’identité ciblée

Sur les bases de ce principe, les experts de McAfee ont reconstitué un système de reconnaissance faciale assez courant dans les aéroports. Notamment pour la vérification des passeports. Ils ont donc mené une expérience pour leurrer ce système. Et ce, en lui faisant confondre une personne avec une autre. Ou plus précisément, en créant une identité de toute pièce.

Un algorithme de traduction d’image StyleGAN

Concrètement, les chercheurs ont créé une image similaire à une personne. Suffisamment réaliste, cet avatar trompe le système de reconnaissance faciale qui le prend pour un véritable individu. Une prouesse rendue possible grâce à générateur de visages hyperréalistes issu du GAN : le StyleGAN, un programme proposé en open source par le groupe Nvidia. Ce véritable faussaire virtuel génère des visages à partir de vraies photos. Sauf que ces visages font preuve d’un tel réalisme que l’on ne peut déterminer s’ils sont réels ou artificiels. Avec la possibilité de générer plusieurs avatars pour une même personne.

Un nouvel avatar, une nouvelle identité

En ce qui concerne l’initiative de McAfee, toute la subtilité de l’opération réside dans l’importance d’une image ressemblant au sujet : pour passer les contrôles humains, l’image générée par le GAN doit pouvoir berner l’œil d’un agent. Tout en faisant croire au système qu’il correspond à un autre sujet. De quoi permettre à un individu de mentir sur son identité et de passer illégalement une frontière.

Un POC pour montrer les vulnérabilités

En tout état de cause, il ne s’agit pas pour les chercheurs d’encourager ce type d’attaque. De fait, cette expérience est une preuve de concept (POC) pour alerter sur les failles de cette technologie. D’ailleurs, l’éditeur d’antivirus se dit prêt à collaborer avec les agences gouvernementales et les acteurs de la biométrie.

Ségolène Kahn

Commentez